VTuberがダンスをする仕組みを解説

こんなことが知りたい

VTuberのダンスはどんな仕組みで動いている?

ここでは、 「VTuberの3Dモデルがダンスをする仕組み」 について解説していきます。

「ライブ配信のときは、どのような仕組みで動いているのか?」 「オフラインのダンスコンテンツを作るときは、どのように作成するのか?」 「人の身体の動きをどのように3Dモデルに適用させるのか?」

3DVRの部署で働いている私が、 できるだけ丁寧に説明していきます。

この記事を書いた人

さくら

- 3DCADサポートエンジニア

- サポート歴7年

- Autodeskとダッソー製品のカスタマーサポートに従事

- 2022年からVR部署の管理職

- 法人向けVRを扱う

詳しい紹介はこちら 「自己紹介」

目次

VTuberどうやって動かしている?

VTuberの3Dモデルがダンスするには、 「モーションキャプチャーのデータを3DCGモデルのアバターに流し込み、 3Dビューワで表示する」 という流れが一般的です。

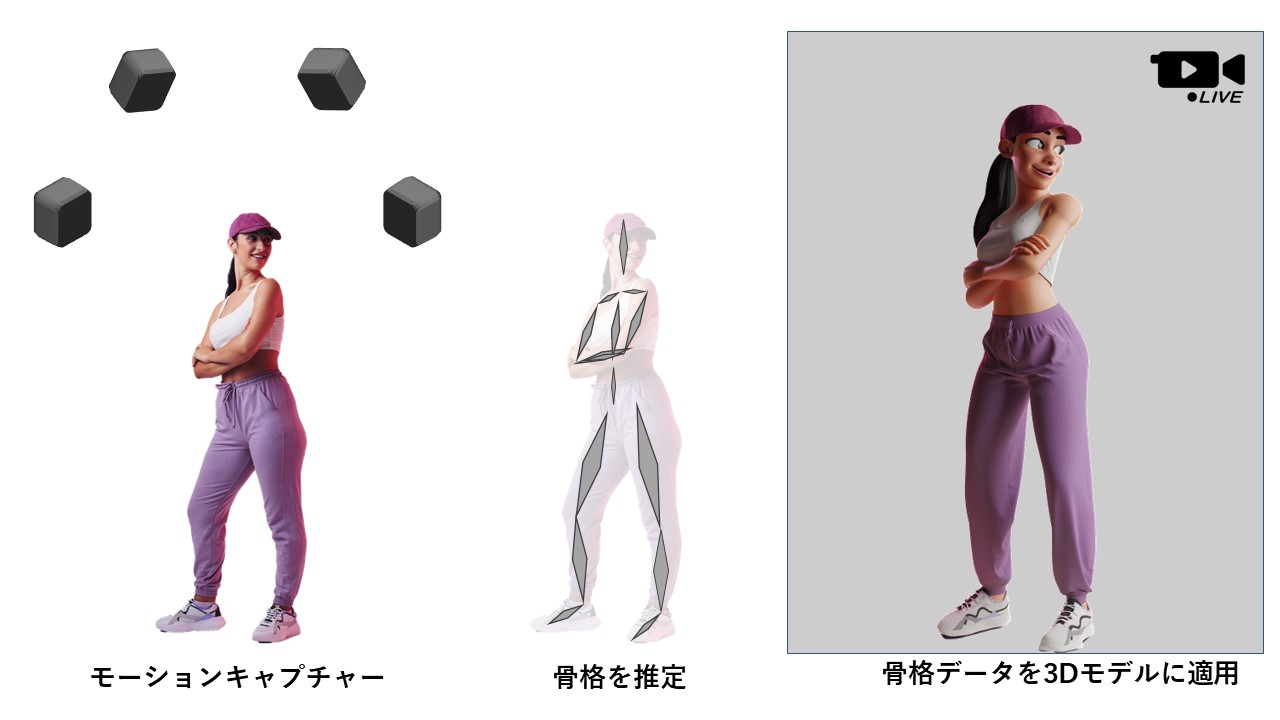

ライブ配信の場合は、 モーションキャプチャーでリアルタイムに3Dモデルの骨格を計算して、 3Dビューワでアバターに変換したものを配信します。 配信映像までの流れは下の図のようになります。

一般的に、モーションキャプチャーは制作会社を通じて、 モーションキャプチャースタジオで撮影します。 いわゆる、法人向けモーションキャプチャを所持していて、 「一日数十万円~」で撮影を請け負ってくれるところが多いです。 ライブ配信の場合は モーションキャプチャースタジオから配信します。

VTuberのアバターは、 Unity、Unreal、Maya、MotionBuilderなどの3Dビューワを使って表示します。 モーションキャプチャーシステムは、 これら3Dビューワへリアルタイムにデータを流せるプラグインソフトがあります。

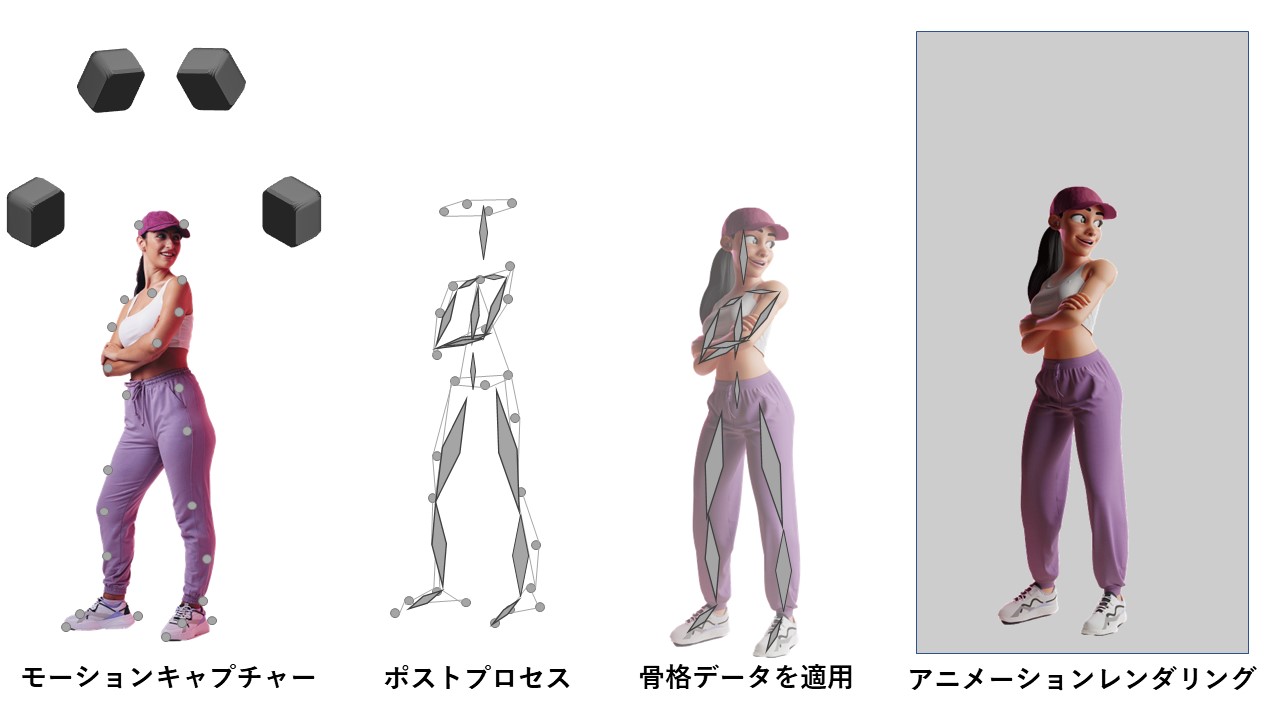

オフラインコンテンツの場合、 まずは、モーションキャプチャーのデータだけを収録します。 オフラインコンテンツ作成の流れは、 下の図のような感じです。

後日、モーションキャプチャーデータのポストプロセス処理をして、 アニメーション作成ができる3DCGソフトのMaya、3ds Max、MotionBuilderのいずれかに データをインポートさせます。

ちなみにポストプロセス処理とは、 データが消えている部分やノイズを除去する作業です。 また、足の接地がじっさいの動きと異なって 離れている部分を修正することもあります。 これは、モーションキャプチャーの専用ソフトで処理をします。

法人向けモーションキャプチャだと、ViconのNexus、Shogunというソフトがあります。 OptitrackだとMotiveというソフト、Xsense MVNだとMVN Animateが専用ソフトにあたります。 おそらく、個人の方が見る機会はほとんどないでしょう。

アニメーション作成では、 モーションキャプチャーデータを編集できる3DCGソフト を使ってモーションキャプチャーデータをインポートしたあと アバターに適用させます。 これによりアバターがダンスをするようになります。 インポートさせたあとに、不自然な動きになっていないかを さらにチェックしていきます。

アニメーションに不自然なところがある場合は、 3DCGソフト側でアニメーションの修正を行います。 この修正を行ったあと、アニメーションをレンダリングして 映像ファイルにするわけです。

ちなみにモーションキャプチャーデータを編集できるソフト はいくつかありますが、有名なのはMaya、MotionBuilder、Blender、3dsMaxがあります。

そのなかでも業界でよく使われるのがMotionBuilderです。 モーションキャプチャーデータを扱ううえで MotionBuilderでできること は多く、法人でのアニメーション作成の作業フローのなかに組み込まれていることが多いです。

そのほか、VTuber活動でのモーションキャプチャーの使われ方についても 別のページで詳細をまとめています。 もし、興味があればそちらも合わせてご覧ください。

VTuber3Dモデルの仕組みは?

さて、VTuberのアバターである「3Dモデル」について もう少し詳しく説明していきます。

VTuberのアバターは、モーションキャプチャーで自然に動くように チューニングされています。

チューニングとは、 「3Dモデルができるだけ高速に3D表示できて、 さらに自然な動きになるようなモデリングをしている」 ということです。

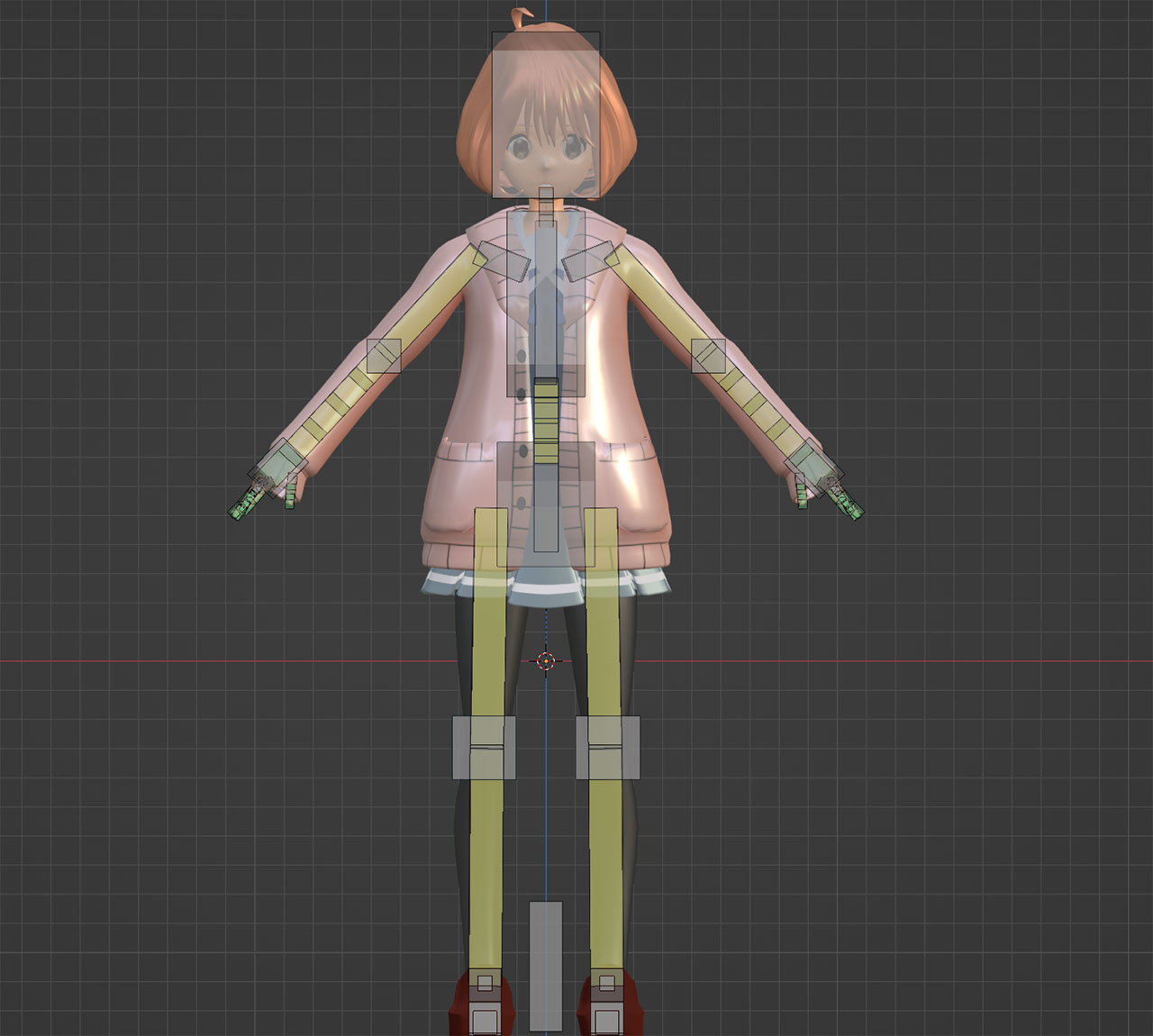

例えば、3Dモデルには「骨格」という設定があります。 人間でいうと骨にあたる部分です。 アバターの骨格については、下の図のような感じです。

この骨格をできるだけ簡素化して、さらに可動域を制限して 腕が胴体にめり込まないようにしたり、 足が変な方向に向かないようにするわけです。

続いて、モーションキャプチャーのデータを 3Dモデルの骨格に適用させる仕組みです。

まずは、モーションキャプチャー側で骨格の位置と姿勢を計算します。 この計算された骨格の動きのデータを3DCGソフト側の3Dモデルの骨格に流し込むことで アバターが動くようになります。

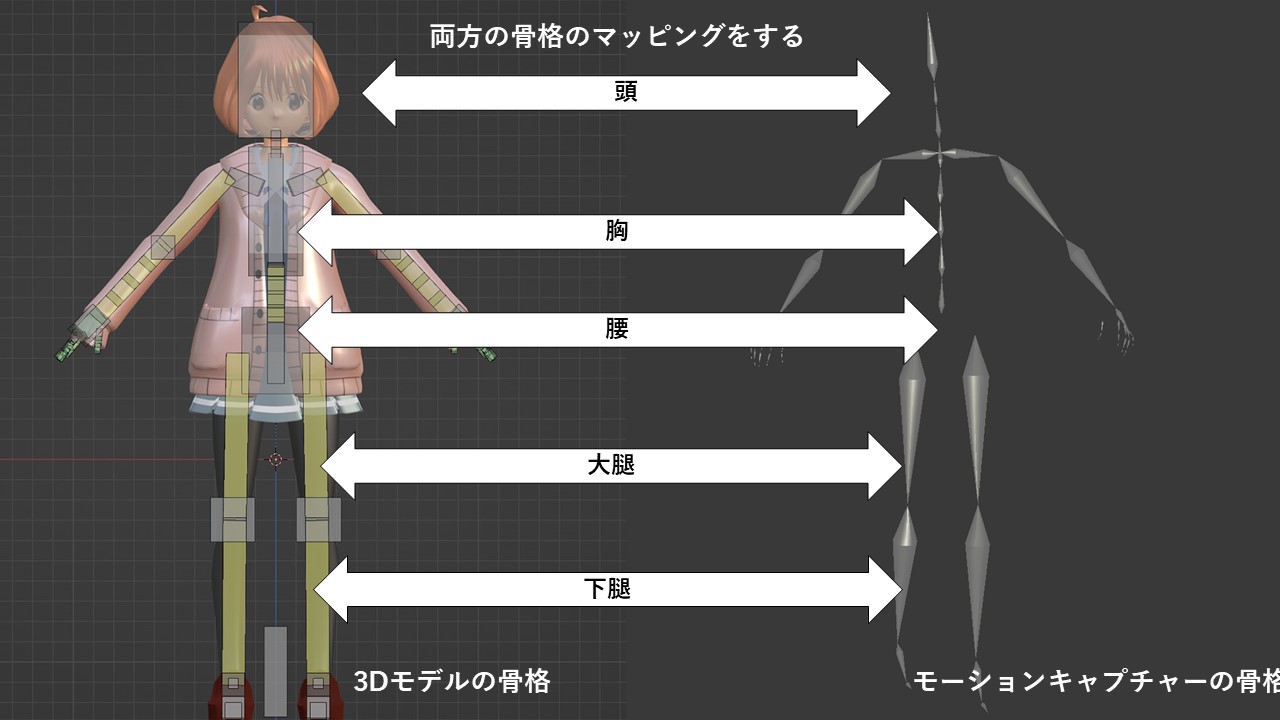

これを実現するには、 「モーションキャプチャーで計算する骨格と 3DCGソフトの3Dモデルの骨格を1対1対応させる必要があります。

ただし、必ずしも両方の骨格の構造が同じである必要はありません。 主要な骨格だけ共通していれば、3DCGソフトの設定でアバターに適用することができます。

例えば、MotionBuilder、MayaではHumanIKという機能を使って モーションキャプチャーで計算する骨格とアバターの骨格データを 対応付けていきます。 UnityではVRIKプラグインというソフトを使うことが多いです。

VTuberの3Dアバターは、 このような仕組みで作られています。

VTuberどうやって撮影する?

さて、VTuberのダンス撮影ですが、 「モーションキャプチャースタジオ」で撮影することが多いです。

モーションキャプチャースタジオでは 主に2種類のモーションキャプチャーを所有していることが多いです。 一つ目が「光学式モーションキャプチャー」 二つ目が「慣性式モーションキャプチャー」です。

ちなみに、「どちらを使うべきか」については、 モーションキャプチャースタジオのスタッフの方が提案してくれます。 最初から最後までコンサルしてくれるわけですね。

光学式モーションキャプチャー

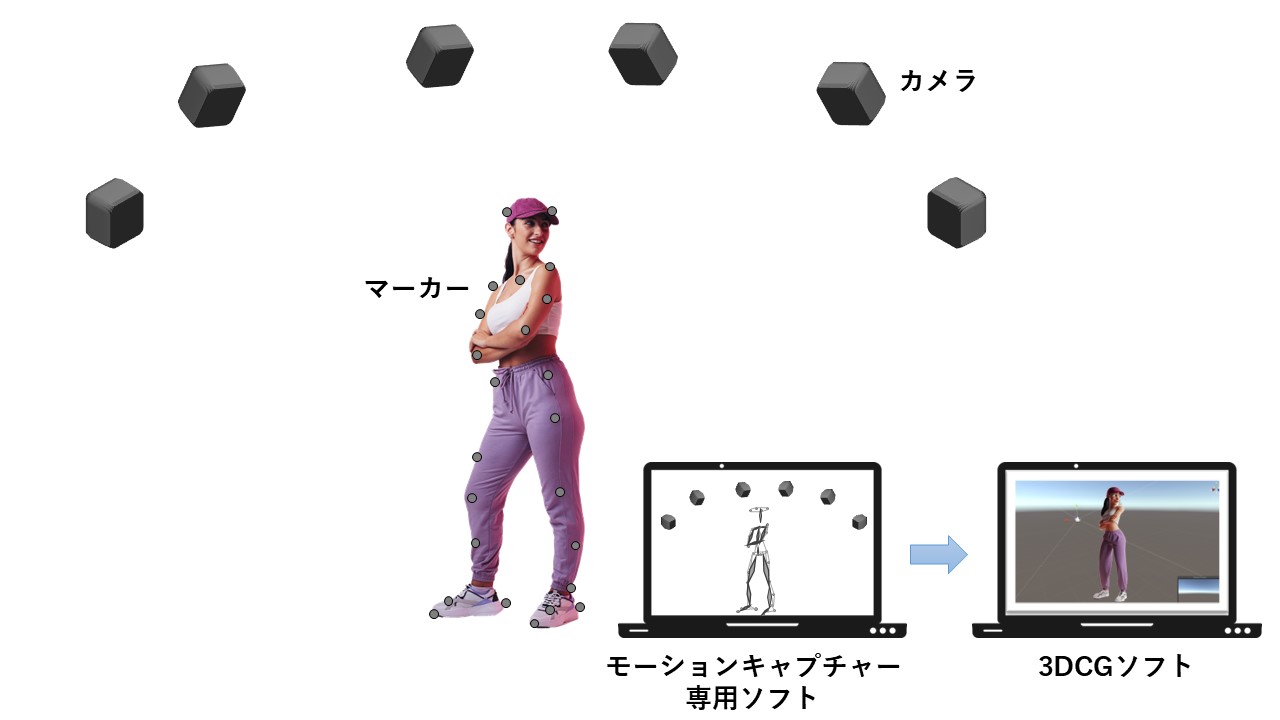

「光学式モーションキャプチャー」では、 ピチッとした専用スーツを着用して、 マーカーと呼ばれるセンサーを身体中につけます。

マーカーは一人当たり40個~50個つけていきます。 骨格の動きを詳細に推定するには、 最低でもこの数が必要になります。

身体につけたマーカーは複数のカメラでとらえます。 ダンスをする演者を囲うようにカメラを配置して、 できるだけ隠れがないように多くのカメラ台数で撮影します。

モーションキャプチャーの専用ソフトで、 この複数のマーカーから「骨格」を計算し、 そのデータを3DCGソフトへ流し込みます。 3DCGソフトで骨格の動きデータをアバターに適用させます。

光学式モーションキャプチャーの具体的な製品にはVicon、Optitrackがあります。 法人向けの超高精度モーションキャプチャーで、 価格も一千万円前後するのが一般的です。

慣性式モーションキャプチャー

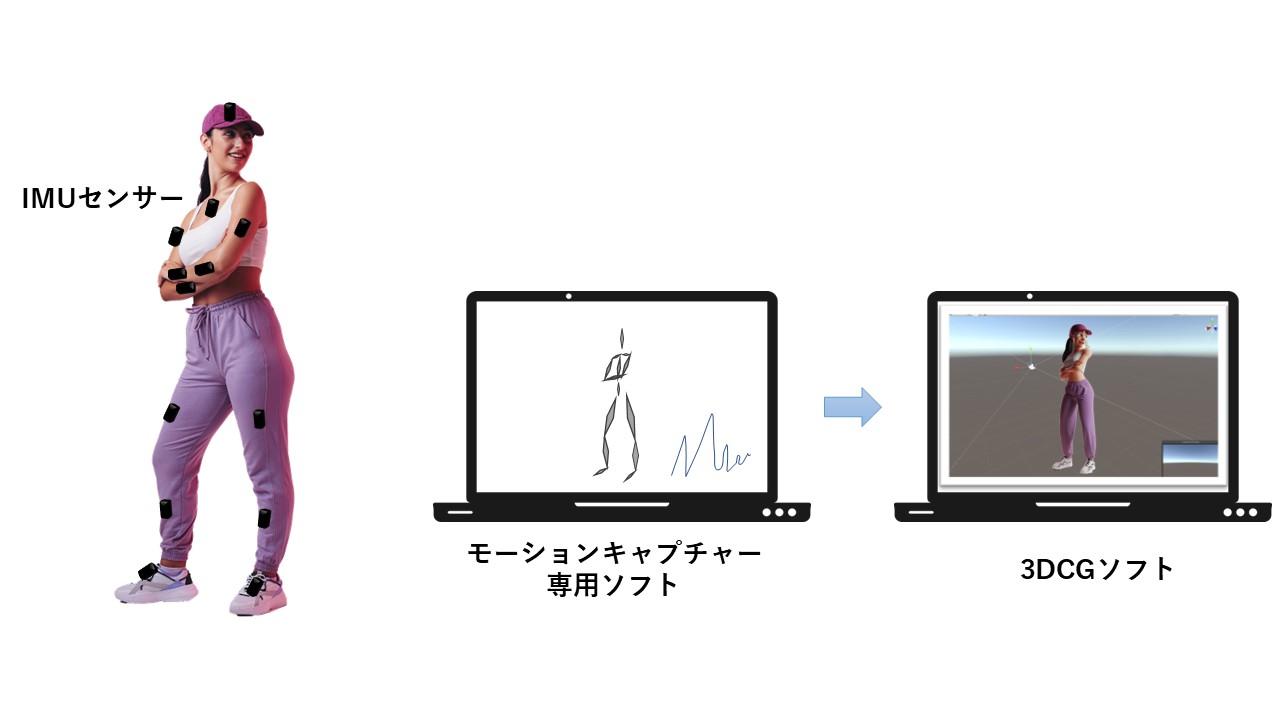

「慣性式モーションキャプチャー」では、 こちらもピチッとした専用スーツを着用して、 IMUと呼ばれるセンサーを身体の主要部分につけていきます。

IMUセンサーは17個つけることが一般的です。 具体的な個所は 「頭、胸、腰、上腕、手首、手、太もも、すね、足首、つま先」です。 手足は左右につけていきます。

モーションキャプチャーの専用ソフトで骨格を推定します。 慣性式モーションキャプチャーでは、 「あらかじめ決められた骨格」になるので、 アバターの3Dモデル骨格との定義づけが必要になります。 Maya、MotionBuilderであればHumanIK機能を使います。

3DCGソフトで骨格の定義づけをすると、 モーションキャプチャーのデータを3Dモデルに適用できます。

慣性式モーションキャプチャーの具体的な製品には Xsens MVNがあります。 価格は光学式モーションキャプチャーより高くはありませんが、 個人で購入できる価格ではありません。

個人向けの慣性式モーションキャプチャーには、 mocopi、Uni-Motion、HaritraXがあります。 こちらは4~5万円前後で購入できます。

ちなみにmocopiのデータは3DアニメーションソフトのMotionBuilderで データを読み込みアニメーション編集ができます。

mocopiのBVHをモーションビルダーで編集する方法 でも解説していますが、比較的簡単にアニメーション編集ができます。

個人向けの慣性式モーションキャプチャーは、法人でのコンテンツ作りではほぼ使いません。 理由は、値段相応の動きの再現性になるためです。 そのため、アニメーション編集で多くの時間がかかってしまいます。 主に個人でVTuberをしている方がダンス動画などを作る場合に使われます。

ダンス動画はどうやって作る?

ここまでは「仕組み」や「撮影方法」を説明してきましたが、 じっさいにどうやってダンス動画になっていくのか?の概要を 説明していきます。

ダンス動画を作るには、大きな流れとして次の3つのステップを踏みます。

- コンテンツ内容を決める

- 撮影する

- 動画に仕上げる

まずは、ダンスの動画コンテンツをどういう内容にするかを決めていきます。

どういうコンセプトで、 どういう人をターゲットにしたコンテンツを作るか、を 考えていきます。

例えば、アニメキャラクターを3DCGで再現してキャラの違う一面を見せるための動画を コンセプトにすることもあります。 いままでは小さい子どもがメインターゲットでしたが、 それを見ている親の世代にも興味を持ってもらうため 新しい技術を使ってコンテンツを作る、みたいな感じです。

プリキュアシリーズのエンディングの3DCGのダンスなんかが それに近いのではないでしょうか。

コンセプトやターゲットが決まったら、 どのような曲で、どのようなダンスを踊って、 どのようなカットの映像にするかといった 具体的な内容を固めていきます。

続いては、モーションキャプチャーの撮影です。

たいていの場合は「モーションキャプチャースタジオ」を運営している 制作会社と一緒になって撮影します。

私が仕事でよくお世話になった会社に MOZOOや デジタルフロンティア などがあります。

はじめに決めたコンテンツ内容に沿って モーションキャプチャーの撮影スケジュールを決めてくれたり 逆に「こうしたほうがいいかも」などの提案もしてくれます。

モーションキャプチャーデータは アニメーションを作るためのソフトにあった形式で納品してくれます。 例えば、MayaやMotionBuilderを使う場合は FBXファイルでもらえたりします。

最後に、動画に仕上げる作業です。

ここでも、3DCG制作をしている会社と一緒になって 動画を仕上げていきます。 よくポストプロダクションと呼ばれる作業です。

モーションキャプチャーデータを3Dキャラクターに適用させて アニメーションを作っていきます。 モーションキャプチャーだけでは表現できない 顔の表情や指先の細かな動きなども追加でアニメーションを作っていきます。

コンテンツ内容にもよりますが、 VFXのような実写合成や音声追加なども行います。 それらを動画編集ソフトでひとつの作品として仕上げて、 「動画」として納品もらうのが一般的です。

この流れは、法人でダンス動画を作るときの流れですが、 個人のVTuberが作るときは、 コンテンツの企画から撮影、そして動画作成まですべてひとりで 行うことが多いです。

そのため、機材の準備にもお金がかかったりします。 個人向けモーションキャプチャー、 3Dアニメーションソフト、 動画編集ソフト、 そしてそれら機器がストレスなく動くパソコンが必須になります。

VTuber向けPCの推奨スペック は、ミドルレンジ以上のゲーミングPCやワークステーションになるので 20~30万円はかかります。 また、MotionBuilder、Mayaもアニメーション作成に必要です。 MotionBuilder、Mayaのようなソフトウェアもけっこう高額です。

個人でVTuberのダンス動画を作るだけでも 初期投資に50~60万円くらいはかかるわけですね。

どんな事例がある?

じっさいにアップロードされているダンスコンテンツの事例を 紹介していきます。

まずはVTuberの先駆者である「キズナアイ」のダンスコンテンツです。 最も迫力があるのは、 活動休止前のラストライブ hello, world 2022 です。

ライブ感を出すための工夫を惜しみなくしていて、 人間が撮ったようなカメラ映像を追求しています。 さらにVTuber独特の作りこまれた動きではなく、 人間っぽさが出る動きになるように3Dモデルを改良しています。

正直、ここまでできるのはキズナアイだったからこそでしょう。 投資額もそうですが、作り手の情熱が半端なく伝わってくるダンスコンテンツです。

もうひとつは、VTuberではないですが、 世界的なアニメキャラ「プリキュア」の3Dダンス動画です。

2009年から各シリーズのエンディングで流れている映像は、 モーションキャプチャーを使った3Dアニメーションです。 映画でも各シリーズのプリキュアが勢ぞろいしてダンスをしています。

セルルックという3Dをアニメ風のタッチに見せる方法で 作ったのがこのダンス動画です。

長い髪やヒラヒラの服は 腕や足にめり込みやすいのですが、 そんなことをみじんも感じさせない編集技術で質の高い動画になっています。

まとめ

「3DモデルVTuberのダンス動作の仕組みを解説」 についてのまとめです。

VTuberの3Dモデルのアバターは、 モーションキャプチャーデータを使って動きを再現している。

ライブ配信の場合はモーションキャプチャーのデータから骨格を推定し、 その骨格データをリアルタイムにアバターに適用させている。 アバターは3DCGソフトで表示する。

オフラインコンテンツの場合は、 モーションキャプチャーのデータを撮影する。 その後、ポストプロセス処理をしてから3DCGソフトに搬入させて アニメーションを作成する。

VTuberの3Dモデルの仕組みは、 自然な動きになるように骨格を設定している。 また、高速に表示できるようにできるだけ単純化させている。

VTuberのダンスは一般的にモーションキャプチャースタジオで撮影することが多い。

モーションキャプチャースタジオでは、 光学式モーションキャプチャーと慣性式モーションキャプチャーの 2種類を用意しているところが多い。

撮影しようとしているダンスが、 どちらのモーションキャプチャーに適しているかは、 スタジオのスタッフが提案してくれる。